Post Syndicated from LGR original https://www.youtube.com/watch?v=UHC438sW_2Q

Comic for 2023.02.03 – In Your Area

Post Syndicated from Explosm.net original https://explosm.net/comics/in-your-area

New Cyanide and Happiness Comic

Security updates for Friday

Post Syndicated from original https://lwn.net/Articles/922112/

Security updates have been issued by Fedora (chromium and vim), Slackware (openssh), and Ubuntu (lrzip and tiff).

Manage and control the use of dedicated egress IPs with Cloudflare Zero Trust

Post Syndicated from Ankur Aggarwal original https://blog.cloudflare.com/gateway-egress-policies/

Before identity-driven Zero Trust rules, some SaaS applications on the public Internet relied on the IP address of a connecting user as a security model. Users would connect from known office locations, with fixed IP address ranges, and the SaaS application would check their address in addition to their login credentials.

Many systems still offer that second factor method. Customers of Cloudflare One can use a dedicated egress IP for this purpose as part of their journey to a Zero Trust model. Unlike other solutions, customers using this option do not need to deploy any infrastructure of their own. However, not all traffic needs to use those dedicated egress IPs.

Today, we are announcing policies that give administrators control over when Cloudflare uses their dedicated egress IPs. Specifically, administrators can use a rule builder in the Cloudflare dashboard to determine which egress IP is used and when, based on attributes like identity, application, IP address, and geolocation. This capability is available to any enterprise-contracted customer that adds on dedicated egress IPs to their Zero Trust subscription.

Why did we build this?

In today’s hybrid work environment, organizations aspire for more consistent security and IT experiences to manage their employees’ traffic egressing from offices, data centers, and roaming users. To deliver a more streamlined experience, many organizations are adopting modern, cloud-delivered proxy services like secure web gateways (SWGs) and deprecating their complex mix of on-premise appliances.

One traditional convenience of these legacy tools has been the ability to create allowlist policies based on static source IPs. When users were primarily in one place, verifying traffic based on egress location was easy and reliable enough. Many organizations want or are required to maintain this method of traffic validation even as their users have moved beyond being in one place.

So far, Cloudflare has supported these organizations by providing dedicated egress IPs as an add-on to our proxy Zero Trust services. Unlike the default egress IPs, these dedicated egress IPs are not shared amongst any other Gateway accounts and are only used to egress proxied traffic for the designated account.

As discussed in a previous blog post, customers are already using Cloudflare’s dedicated egress IPs to deprecate their VPN use by using them to identify their users proxied traffic or to add these to allow lists on third party providers. These organizations benefit from the simplicity of still using fixed, known IPs, and their traffic avoids the bottlenecks and backhauling of traditional on-premise appliances.

When to use egress policies

The Gateway Egress policy builder empowers administrators with enhanced flexibility and specificity to egress traffic based on the user’s identity, device posture, source/destination IP address, and more.

Traffic egressing from specific geolocations to provide geo-specific experiences (e.g. language format, regional page differences) for select user groups is a common use case. For example, Cloudflare is currently working with the marketing department of a global media conglomerate. Their designers and web experts based in India often need to verify the layout of advertisements and websites that are running in different countries.

However, those websites restrict or change access based on the geolocation of the source IP address of the user. This required the team to use an additional VPN service for just this purpose. With egress policies, administrators can create a rule to match the domain IP address or destination country IP geolocation and marketing employees to egress traffic from a dedicated egress IP geo-located to the country where they need to verify the domain. This allows their security team to rest easy as they no longer have to maintain this hole in their perimeter defense, another VPN service just for marketing, and can enforce all of their other filtering capabilities to this traffic.

Another example use case is allowlisting access to applications or services maintained by a third party. While security administrators can control how their teams access their resources and even apply filtering to their traffic they often can’t change the security controls enforced by third parties. For example, while working with a large credit processor they used a third party service to verify the riskiness of transactions routed through their Zero Trust network. This third party required them to allowlist their source IPs.

To meet this goal, this customer could have just used dedicated egress IPs and called it a day, but this means that all of their traffic is now being routed through the data center with their dedicated egress IPs. So if a user wanted to browse any other sites they would receive a subpar experience since their traffic may not be taking the most efficient path to the upstream. But now with egress policies this customer can now only apply this dedicated egress IP to this third party provider traffic and let all other user traffic egress via the default Gateway egress IPs.

Building egress policies

To demonstrate how easy it is for an administrator to configure a policy let’s walk through the last scenario. My organization uses a third-party service and in addition to a username/password login they require us to use a static source IP or network range to access their domain.

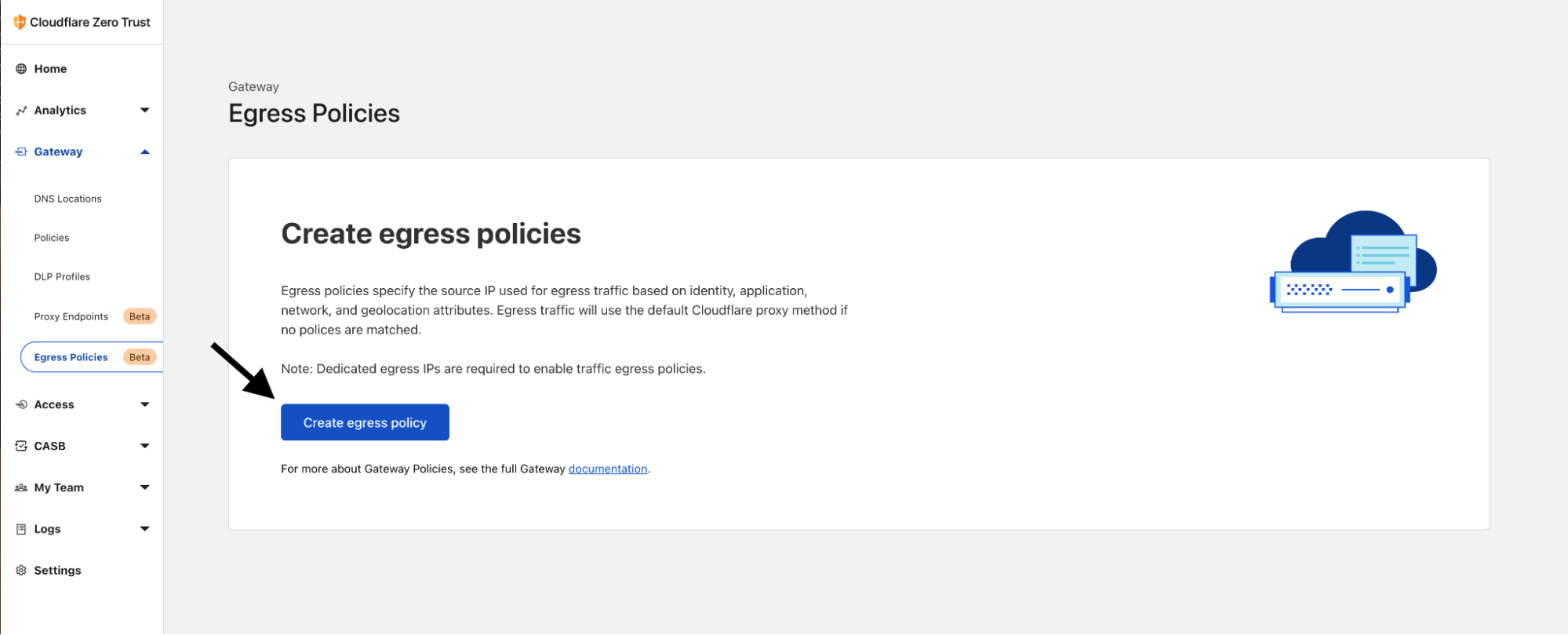

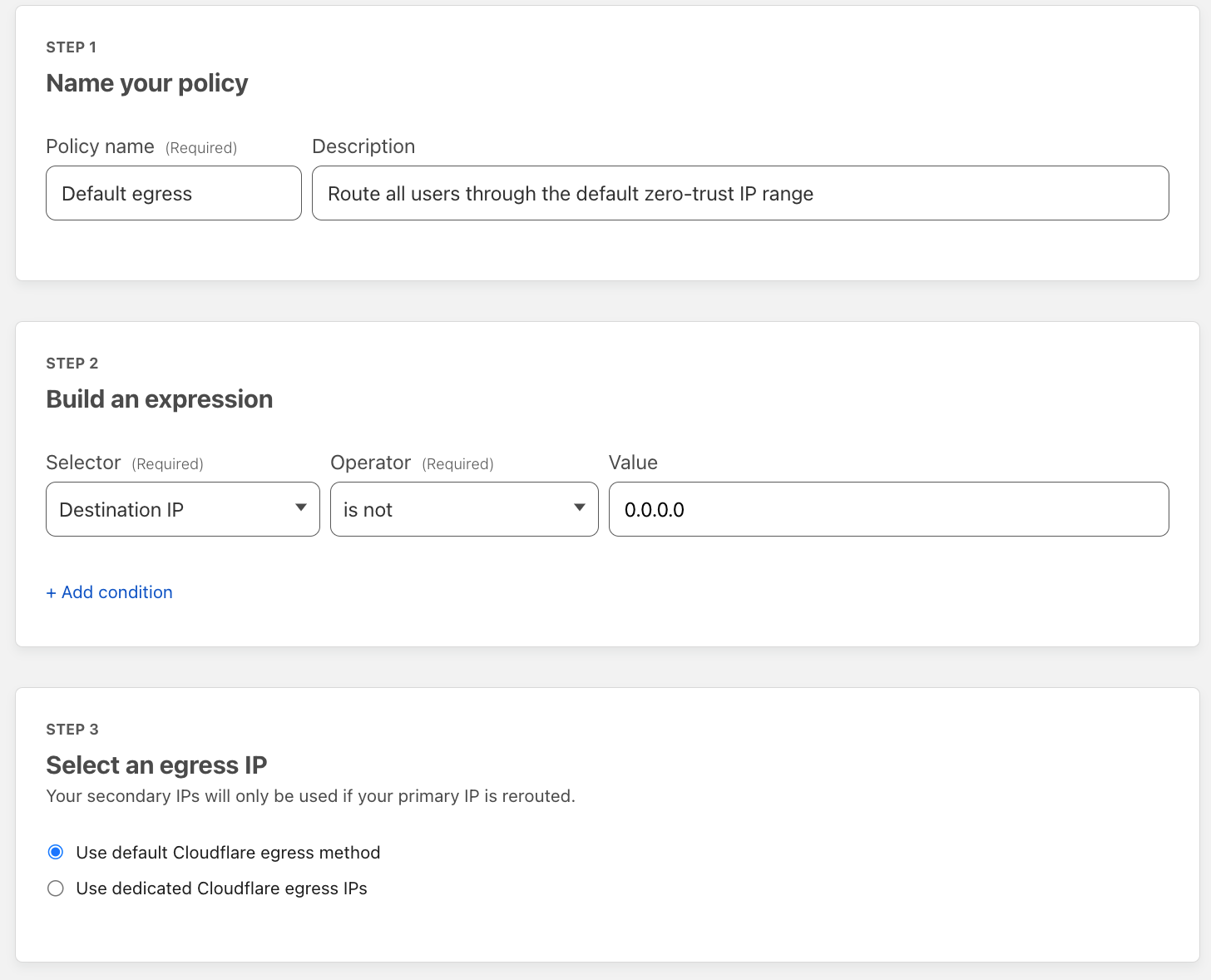

To set this up, I just have to navigate to Egress Policies under Gateway on the Zero Trust dashboard. Once there I can hit ‘Create egress policy’:

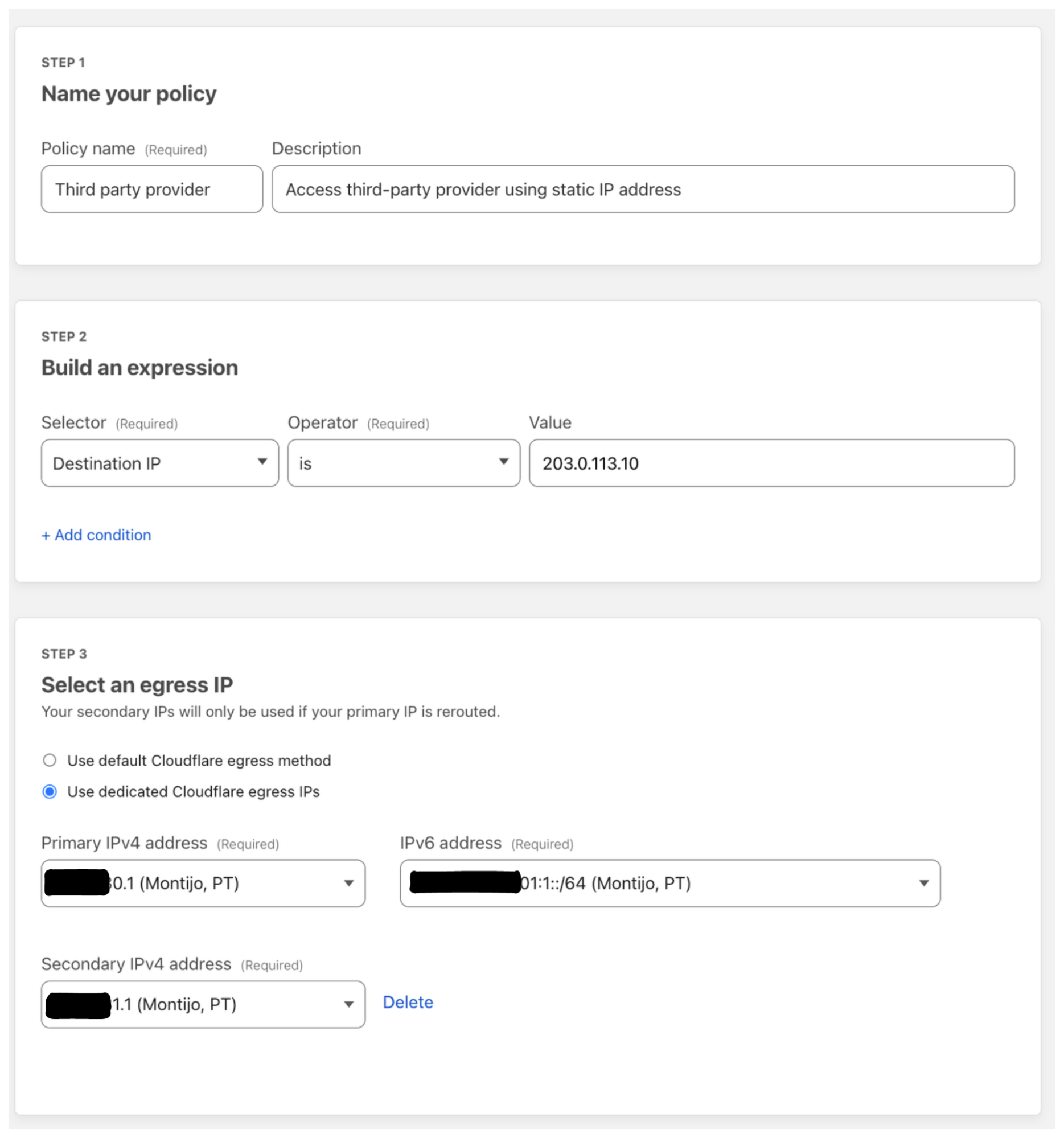

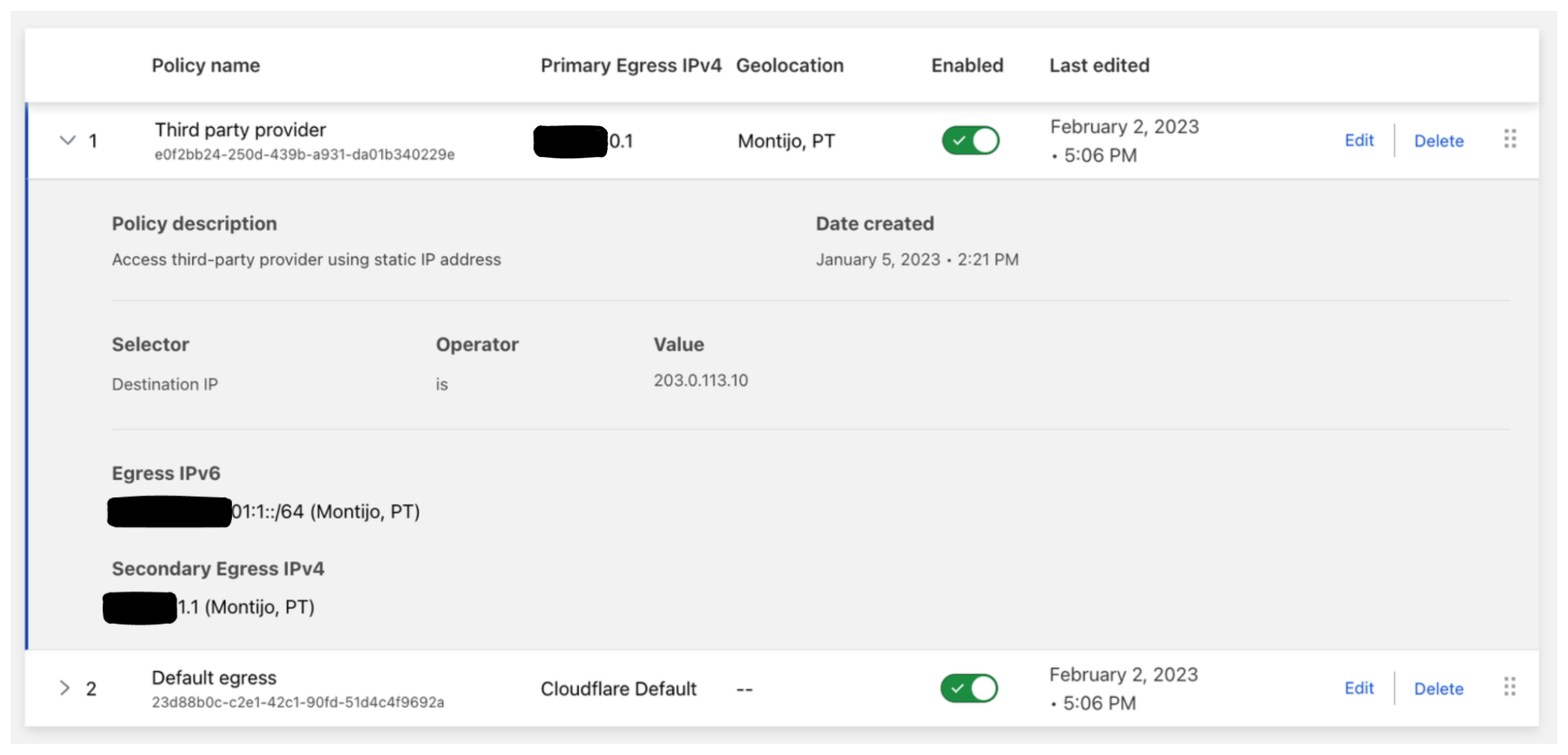

For my organization most of my users accessing this third-party service are located in Portugal so I’ll use my dedicated egress IPs that are assigned to Montijo, Portugal. The users will access example.com hosted on 203.0.113.10 so I’ll use the destination IP selector to match all traffic to this site; policy configuration below:

Once my policy is created, I’ll add in one more as a catch-all for my organization to make sure they don’t use any dedicated egress IPs for destinations not associated with this third-party service. This is key to add in because it makes sure my users receive the most performant network experience while still maintaining their privacy by egress via our shared Enterprise pool of IPs; policy configuration below:

Taking a look at the egress policy list we can see both policies are enabled and now when my users try to access example.com they will be using either the primary or secondary dedicated IPv4 or the IPv6 range as the egress IP. And for all other traffic, the default Cloudflare egress IPs will be used.

Next steps

We recognize that as organizations migrate away from on-premise appliances, they want continued simplicity and control as they proxy more traffic through their cloud security stack. With Gateway egress policies administrators will now be able to control traffic flows for their increasingly distributed workforces.

If you are interested in building policies around Cloudflare’s dedicated egress IPs, you can add them onto a Cloudflare Zero Trust Enterprise plan or contact your account manager.

Get notified about the most relevant events with Advanced HTTP Alerts

Post Syndicated from Justin Raczak original https://blog.cloudflare.com/custom-alert-features-anomaly-detection/

Today we’re excited to be announcing more flexibility to HTTP alerting, enabling customers to customize the types of activity they’re alerted on and how those alerts are organized.

Prior to today, HTTP alerts at Cloudflare have been very generic. You could choose which Internet properties you wanted and what sensitivity you wanted to be alerted on, but you couldn’t choose anything else. You couldn’t, for example, exclude the IP addresses you use to test things. You couldn’t choose to monitor only a specific path. You couldn’t choose which HTTP statuses you wanted to be alerted on. You couldn’t even choose to monitor your entire account instead of specific zones.

Our customers leverage the Cloudflare network for a myriad of use cases ranging from decreasing bandwidth costs and accelerating asset delivery with Cloudflare CDN to protecting their applications against brute force attacks with Cloudflare Bot Management. Whether the reasons for routing traffic through the Cloudflare network are simple or complex, one powerful capability that comes for free is observability.

With traffic flowing through the network, we can monitor and alert customers about anomalous events such as spikes in origin error rates, enabling them to investigate further and mitigate any issues as necessary. But to date, our HTTP alerting capabilities have been too simple, offering only a narrow set of options for filtering alongside predefined service level objective (SLO) targets. By exposing more of the metadata already available with each request as filtering options, customers can create more sophisticated monitoring schemes to answer important questions about their traffic.

Which HTTP errors are crossing my SLO threshold? Is the sudden spike in traffic caused by my own internal testing? These questions and more can be answered with the new advanced HTTP alerts.

Alerts can be filtered and organized based on the values of the following properties: origin response status codes, edge response status codes, alert sensitivity/SLO, client IPv4/IPv6 addresses, and specific zones.

The new notifications are available to all Enterprise customers today and can be created and managed by anyone with account-level privileges.

How to get started

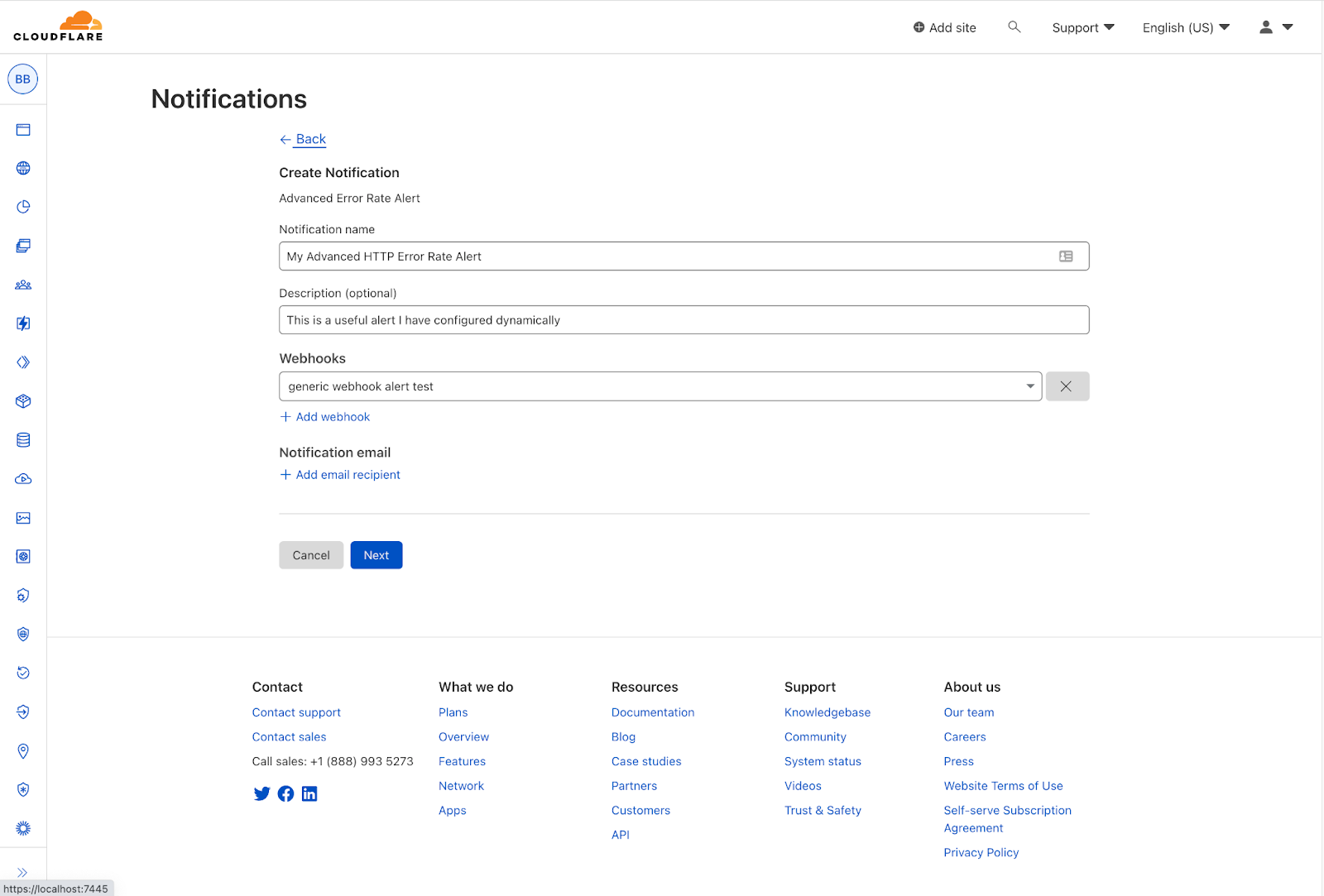

To get started setting up an advanced HTTP alert, navigate to your account’s notification management and select the Advanced HTTP Alert type.

Next, name your new notification and select how you want notifications to be delivered and to whom.

Lastly, select the domains for which this notification should be sent and configure the desired filters, groupings, and SLO.

Monitoring and alerting are critical practices in effectively managing an application or website, and today we’re excited to make it easier to do with Cloudflare.

If you’re not already an Enterprise customer and would like to take advantage of the new advanced HTTP alerts, get in touch.

The Pirate Monk and Robin Hood

Post Syndicated from The History Guy: History Deserves to Be Remembered original https://www.youtube.com/watch?v=_fLY9MJWGXQ

What’s Up, Home? – Baby, Don’t Cry

Post Syndicated from Janne Pikkarainen original https://blog.zabbix.com/whats-up-home-baby-dont-cry/25354/

Can you detect a crying baby with Zabbix? Of course, you can! By day, I am a monitoring tech lead in a global cyber security company. By night, I monitor my home with Zabbix & Grafana and do some weird experiments with them. Welcome to my blog about the project.

Time really flies. Our little baby girl at home is already about three and a half months old, and that shows in so many ways. If during her first month or two she cried quite a lot and quite easily due gassy stomach and whatnot, she nowadays mostly is a chill mini-human just observing the world.

Which then raised the question for me — how often she cries? Could I monitor that? Oh yes. And oh no. We’ll get to no part later, but let’s start with the good bits.

Hey Siri, help me

As I pretty much always have my iPhone with or near me, and wear my Apple Watch nearly 24×7, I thought I would give their sound recognition abilities a try.

To start, I opened the Settings on my iPhone and went to Accessibility → Sound recognition → Baby crying and enabled that.

Next, I opened Shortcuts and created a new Personal automation.

So, every time my iDevice thinks that our baby is crying, it appends to a text file stored on my iCloud account.

Zabbix Time!

How to get that data to Zabbix?

I have a MacBook Pro and a Zabbix agent running on that, so the next natural step was to make it monitor that particular text file. There would be so many ways to detect if this file has been changed; as I’m appending to the text file, I just made Zabbix keep an eye on the file size.

How does that look like on my graphs? Not so surprisingly, the value changes.

I also set up a simple trigger that screams if the file size has changed since the last check.

The result? Well, here’s some alert history.

Sleep Learn Adapt reporting

I also added our baby as a Service to my Zabbix, just because it was too fun to skip as the terminology involves child services, parent services and such.

And here’s a totally inaccurate and unmeaningful SLA report about her.

The wobbly bits

Just like our baby is still clumsy and has a lot to learn, it seems that Siri is like that too when it comes to detecting emotions. Yes, Siri can detect if our baby is crying, but it also easily gets worried whenever our baby makes loud joyful sounds. It reminds me of the golden times when T-800 practiced smiling. It just doesn’t know or understand human feelings. At least, not yet.

Then the other odd part is that about one day after I enabled the cry detection on my iPhone, it’s not doing it anymore. Did the detection process crash? Probably. I have not restarted my iPhone yet, because I just could not bother to do that yet. But, in theory, we can detect a crying baby, or many more usual sounds like a doorbell, a dog barking just by using Siri and Zabbix.

I have been working at Forcepoint since 2014 and I think my human skills still beat the ones Siri has. — Janne Pikkarainen

This post was originally published on the author’s LinkedIn account.

Manipulating Weights in Face-Recognition AI Systems

Post Syndicated from Bruce Schneier original https://www.schneier.com/blog/archives/2023/02/manipulating-weights-in-face-recognition-ai-systems.html

Interesting research: “Facial Misrecognition Systems: Simple Weight Manipulations Force DNNs to Err Only on Specific Persons“:

Abstract: In this paper we describe how to plant novel types of backdoors in any facial recognition model based on the popular architecture of deep Siamese neural networks, by mathematically changing a small fraction of its weights (i.e., without using any additional training or optimization). These backdoors force the system to err only on specific persons which are preselected by the attacker. For example, we show how such a backdoored system can take any two images of a particular person and decide that they represent different persons (an anonymity attack), or take any two images of a particular pair of persons and decide that they represent the same person (a confusion attack), with almost no effect on the correctness of its decisions for other persons. Uniquely, we show that multiple backdoors can be independently installed by multiple attackers who may not be aware of each other’s existence with almost no interference.

We have experimentally verified the attacks on a FaceNet-based facial recognition system, which achieves SOTA accuracy on the standard LFW dataset of 99.35%. When we tried to individually anonymize ten celebrities, the network failed to recognize two of their images as being the same person in 96.97% to 98.29% of the time. When we tried to confuse between the extremely different looking Morgan Freeman and Scarlett Johansson, for example, their images were declared to be the same person in 91.51% of the time. For each type of backdoor, we sequentially installed multiple backdoors with minimal effect on the performance of each one (for example, anonymizing all ten celebrities on the same model reduced the success rate for each celebrity by no more than 0.91%). In all of our experiments, the benign accuracy of the network on other persons was degraded by no more than 0.48% (and in most cases, it remained above 99.30%).

It’s a weird attack. On the one hand, the attacker has access to the internals of the facial recognition system. On the other hand, this is a novel attack in that it manipulates internal weights to achieve a specific outcome. Given that we have no idea how those weights work, it’s an important result.

Имаше такъв парламент. Защо?

Post Syndicated from Емилия Милчева original https://www.toest.bg/imashe-takyv-parlament-zashto/

Само след няколко месеца единственото паметно за 48-мото Народно събрание е, че върна хартиената бюлетина в изборната игра и се провали в приемането на механизъм за разследване на главния прокурор. Хартиената бюлетина беше първата му работа, а със съдебната реформа парламентът се зае в условията на предизвестен край – броени дни преди да бъде разпуснат. Изглежда, че са успели „да продадат и мача за еврозоната“ (по израза на вицепремиера Атанас Пеканов), саботирайки промените в Кодекса за застраховането.

За тези незаличими дела в 48-мия парламент мнозинство се намери: фундаментът му бяха ГЕРБ–ДПС–БСП, формиращи при необходимост плаващи мнозинства с „Български възход“ и „Възраждане“. Въпреки наличие на такива… болшинства Народното събрание се провали и в трите опита за съставяне на правителство.

Голата истина

Парадоксално, нали? Само на пръв поглед. По-лесно е да се съберат биячи на реформите, отколкото кандидати да управляват заедно. ГЕРБ може и да се разбере с „Възраждане“ за общи действия в парламента, но не и за нещо повече. Не защото в политиката има срам и свян, а защото войната на Русия срещу Украйна и политическите и човешките избори, които налага, правят немислими коалициите с партии, симпатизиращи на режима на Путин и виждащи евразийският избор като верния път.

Коалициите на ГЕРБ с патриотични формации, каквито имаше при второто и третото правителство на Бойко Борисов, едва ли ще бъдат повторени. Ако БСП продължава да изглежда като мек вариант на „Възраждане“, също може да бъде изключена от кръга на приемливите партньори – независимо от анонсите на Борисов след срещата в парламента, на която се отзова по покана на Корнелия Нинова.

Това напълно устройва „Възраждане“ и драматичния театър на антисистемните българи-юнаци, които не искат да се коалират с никого и декларират, че ще управляват сами. А и техните избиратели не се интересуват дали партията, за която гласуват, е нечий пудел и се заиграва с политическите сили на статуквото, стига да бие „евробабаитите“ – с подписка за референдум, насочен срещу еврото, с юмруците на сина на партийния лидер, с гръмовните речи на Костадин Костадинов.

„Най-лошото от всичко обаче е, че хората, които полагат клетва да се ръководят във всяко свое действие от интересите на народа ни, в голямата си част са напълно лишени от срам и съвест“, каза самият той в първата си реч в парламента. Голата истина – достатъчно е да погледнем колко срамни части лъснаха в пленарната зала.

В евро-атлантизма обаче 48-мият парламент се отсрами. С гласовете на ГЕРБ, „Продължаваме промяната“, ДПС, „Демократична България“ и „Български възход“ беше решено България да предостави безвъзмездна военна помощ на Украйна. Става въпрос за въоръжение, техника и боеприпаси за 20 млн. лв., след като за 2022 г. българската оръжейна индустрия е изнесла стоки с краен получател Полша и Чехия за 5 млрд. лв. – и експортът продължава. Същото „евро-атлантическо мнозинство“, с известна редукция откъм депутати на ПП, одобри и сделка за още 8 американски изтребителя F-16 Block 70. Пак то обяви за геноцид Гладомора в Украйна от 1932–1933 г., предизвикан от съветския режим и погубил над 4 млн. души.

И при трите гласувания БСП и „Възраждане“ бяха против. Не може да се отрече последователността в редиците на БСП – и корнелниновистите, и вътрешнопартийната опозиция са единни, когато въпросът опре до Русия и защитата на нейните интереси. В Европейския парламент петимата евродепутати на БСП начело с доскорошния председател на ПЕС Сергей Станишев изобщо не участваха във вота на резолюцията, осъждаща Гладомора, като се измъкваха, въздържаха или бяха против при гласувания по други „руски въпроси“.

Въпреки това социалистите може отново да се озоват във властта. Не е ясно дали ще ги карат да се отрекат трижди от Путин и Кремъл – или ще е достатъчно просто да покажат прогресивно мислене в духа на интервюто по bTV на Андрей Гюров (ПП):

В ръцете на БСП е да реши зад кои принципи и идеи за управление на страната да застане – зад тези на новата „тройна коалиция“ или на прогресивните реформаторски сили.

Какво мисли останалата част от прогресивните сили – „Демократична България“ – за съюз с БСП, засега е неизвестно. Все пак социалистите подкрепиха законопроекта на ДБ при крайна необходимост държавата да може да поеме оперативен контрол над активите на „Лукойл“ в България, както и на всички други оператори на нефт и нефтопродукти.

Стендбай за еврото

Евро-атлантици в българската версия не значи и европейци. Европейската интеграция например беше опраскана по всички неписани уйдурми на българската парламентарна демокрация. Тези, които се кълняха в пътя към еврото, на практика го отрязаха. Законопроектите, подготвени от Министерството на финансите, които трябваше да бъдат гласувани – за промени в Кодекса за застраховане, за мерките срещу изпирането на пари и промени в Търговския закон – не минаха въпреки предупрежденията на финансовия министър Росица Велкова.

„Проблемът със „Зелена карта“ до такава степен е ескалирал, че е поставен като изискване за приемането ни в еврозоната“, каза Велкова. От 2018 г. на България е наложен мониторинг и виси заплахата да бъде изключена от системата „Зелена карта“, действаща в 48 държави, тъй като не плаща искания по „Гражданска отговорност“ срещу местни застрахователи заради пътни инциденти в чужбина.

Но въпреки че промяната в Кодекса за застраховане задължава бюрото „Зелена карта“ да спазва своя принцип „първо плащай, после оспорвай“, тя не мина. Тихата коалиция между ГЕРБ, ДПС, БСП, „Възраждане“ и „Български възход“ провали заседанието на Комисията по икономическа политика въпреки перманентни уверения на първите две партии, че са радетели за еврото.

Това се прави от хора, които не искат на този пазар да има европейска регулация… заради интересите на Алексей Петров („Лев Инс“, б.а.) и невъзможността на Бойко Борисов да се откъсне от своята биография плащаме данък минало, заяви по bTV съпредседателят на ДБ Христо Иванов.

Промените в Търговския закон, свързани с несъстоятелността – процес, с чиято тромавост и продължителност България се слави в Европа, също не се класираха за окончателно приемане в дневния ред на депутатите. През декември парламентът прие на първо четене законопроекта, който урежда и процедурата за фалит на лицата, които се занимават със стопанска дейност, но не са търговци. До второ не се стигна.

Възпрян за второ четене беше и законопроектът за мерките срещу изпирането на пари, срещу който възразиха някои работодателски организации и застрахователни компании, тъй като въвежда механизъм за идентифициране на лицата, предоставящи услуги по дружествено управление, и процедури за проверката им (адвокати, счетоводители, данъчни съветници и др.), както и допълнителни изисквания към прокуристи, управители, членове на управителни или контролни органи.

През април България трябва да поиска оценка на готовността си за присъединяване към еврозоната от 1 януари 2024 г., тоест да бъде оценено изпълнението на критериите. Но законодателните пропуски няма как да бъдат наваксани дотогава: парламентът се разпуска, изборите са на 2 април, 49-тото Народно събрание ще се конституира след седмица, има и великденски празници. Така че дори твърде високата инфлация в България да се охлади и задържи (критериите за дълга и дефицита са дерогирани), пакета закони, който се изисква, го няма. Влияние ще окаже и липсата на бюджет за 2023 г., с който върви и тригодишната бюджетна прогноза, необходими за конвергентен доклад.

Това е най-големият провал на 48-мия парламент – че направи всичко, за да осуети следващата стъпка за европейска интеграция на България, независимо от декларативните заявки и решение, с което задължи служебното правителство да ускори процеса и да започне информационна кампания (каквато правителството изобщо не начена въпреки подписката за референдум на „Възраждане“, разпалваща страховете от единната европейска валута).

Трохи за избирателите

Няма как да се мине без трохи за избирателите в година на поне два сигурни вота – предсрочни парламентарни, пети поред за две години, и местни избори наесен. Безплатни учебници, но от учебната 2024-та/2025-та, ще има и за по-големите ученици от VIII до ХII клас, а не само за тези от I до VII клас. Пак от догодина минималната работна заплата ще стане 50% от средната брутна работна заплата за предходните 12 месеца.

Парламентът успя да поправи и една несправедливост спрямо хората с увреждания – решенията на ТЕЛК ще важат до явяването на гражданите пред комисия, за да запазят правата си и инвалидната пенсия, която получават до преосвидетелстване. Сега НОИ спираше парите и в продължение на месеци, докато траеше процедурата, хората с увреждания бяха лишени от пенсии.

С огромно закъснение и ДПС предложи принудителният престой в затвори и места за задържане да се признава за трудов и осигурителен стаж при пенсиониране. Така стотици български мюсюлмани, репресирани по време на насилствената смяна на имената, ще получат, макар и незначително, увеличение на пенсиите си.

В последния момент парламентът гласува да има финансова помощ от държавата и за аптеки в отдалечени места, както и за единствените денонощни за даден район, които отпускат лекарства по Здравна каса през нощта. Тази мярка обаче може да се задейства, когато има нов бюджет.

Същото важи и за друга мярка – регулиране на възнагражденията на медиците в болниците, които не трябва да са по-ниски от договореното в колективния трудов договор. Причината е, че съдът отмени КТД от 2022 г., в който бяха заложени минимални заплати от 1500 лв. за медицинска сестра и 2000 лв. за лекар без специалност, и сестрите продължиха да получават мизерни възнаграждения.

В същото време служебното правителство на президента бележеше успех след успех. Пусна в експлоатация интерконектора с Гърция. Осигури количества втечнен газ и запълни газохранилището в Чирен. Получи от Европейската комисия първия транш от 1,2 млрд. евро по Плана за възстановяване и устойчивост – докато парламентът провали втория от 724 млн. евро, тъй като не успя да приеме необходимите закони начело с този за разследването на главния прокурор. Намери над 776 млн. лв., за да плати на пътни фирми за изграждане и поддръжка на пътищата в страната, от които близо 440 милиона са по договори, сключени още при третия кабинет на Бойко Борисов. Удължи енергийните помощи за бизнеса до март.

Президентът Радев и сръбският му колега Вучич поставиха началото на газовата връзка със Сърбия. Служебният кабинет се опитва да постави на енергийната карта нефтопровода Бургас–Александруполис заедно с гръцкото правителство. А същевременно извърши куп назначения на препоръчани неизвестно от кого хора на възлови места и с това бетонира кръга президентски назначения, започнал със смените в спецслужбите. Докато нито 47-мият, нито 48-мият парламент успя да изпълни задълженията си, обновявайки състава на регулатори, комисии и органи на съдебната власт с изтекъл от години мандат.

Същинската вреда от работата на 48-мото Народно събрание е именно в принизяването на парламентарната демокрация и инструментализирането ѝ от президента. Това покушение ще има дългосрочни последици.

Заглавно изображение: Сградата на парламента в деня, в който депутатите от 48-мото Народно събрание положиха клетва. Снимка: parliament.bg

Имаше такъв парламент. Защо?

Post Syndicated from Емилия Милчева original https://www.toest.bg/imashe-takyv-parlament-zashto/

Само след няколко месеца единственото паметно за 48-мото Народно събрание е, че върна хартиената бюлетина в изборната игра и се провали в приемането на механизъм за разследване на главния прокурор. Хартиената бюлетина беше първата му работа, а със съдебната реформа парламентът се зае в условията на предизвестен край – броени дни преди да бъде разпуснат. Изглежда, че са успели „да продадат и мача за еврозоната“ (по израза на вицепремиера Атанас Пеканов), саботирайки промените в Кодекса за застраховането.

За тези незаличими дела в 48-мия парламент мнозинство се намери: фундаментът му бяха ГЕРБ–ДПС–БСП, формиращи при необходимост плаващи мнозинства с „Български възход“ и „Възраждане“. Въпреки наличие на такива… болшинства Народното събрание се провали и в трите опита за съставяне на правителство.

Голата истина

Парадоксално, нали? Само на пръв поглед. По-лесно е да се съберат биячи на реформите, отколкото кандидати да управляват заедно. ГЕРБ може и да се разбере с „Възраждане“ за общи действия в парламента, но не и за нещо повече. Не защото в политиката има срам и свян, а защото войната на Русия срещу Украйна и политическите и човешките избори, които налага, правят немислими коалициите с партии, симпатизиращи на режима на Путин и виждащи евразийският избор като верния път.

Коалициите на ГЕРБ с патриотични формации, каквито имаше при второто и третото правителство на Бойко Борисов, едва ли ще бъдат повторени. Ако БСП продължава да изглежда като мек вариант на „Възраждане“, също може да бъде изключена от кръга на приемливите партньори – независимо от анонсите на Борисов след срещата в парламента, на която се отзова по покана на Корнелия Нинова.

Това напълно устройва „Възраждане“ и драматичния театър на антисистемните българи-юнаци, които не искат да се коалират с никого и декларират, че ще управляват сами. А и техните избиратели не се интересуват дали партията, за която гласуват, е нечий пудел и се заиграва с политическите сили на статуквото, стига да бие „евробабаитите“ – с подписка за референдум, насочен срещу еврото, с юмруците на сина на партийния лидер, с гръмовните речи на Костадин Костадинов.

„Най-лошото от всичко обаче е, че хората, които полагат клетва да се ръководят във всяко свое действие от интересите на народа ни, в голямата си част са напълно лишени от срам и съвест“, каза самият той в първата си реч в парламента. Голата истина – достатъчно е да погледнем колко срамни части лъснаха в пленарната зала.

В евро-атлантизма обаче 48-мият парламент се отсрами. С гласовете на ГЕРБ, „Продължаваме промяната“, ДПС, „Демократична България“ и „Български възход“ беше решено България да предостави безвъзмездна военна помощ на Украйна. Става въпрос за въоръжение, техника и боеприпаси за 20 млн. лв., след като за 2022 г. българската оръжейна индустрия е изнесла стоки с краен получател Полша и Чехия за 5 млрд. лв. – и експортът продължава. Същото „евро-атлантическо мнозинство“, с известна редукция откъм депутати на ПП, одобри и сделка за още 8 американски изтребителя F-16 Block 70. Пак то обяви за геноцид Гладомора в Украйна от 1932–1933 г., предизвикан от съветския режим и погубил над 4 млн. души.

И при трите гласувания БСП и „Възраждане“ бяха против. Не може да се отрече последователността в редиците на БСП – и корнелниновистите, и вътрешнопартийната опозиция са единни, когато въпросът опре до Русия и защитата на нейните интереси. В Европейския парламент петимата евродепутати на БСП начело с доскорошния председател на ПЕС Сергей Станишев изобщо не участваха във вота на резолюцията, осъждаща Гладомора, като се измъкваха, въздържаха или бяха против при гласувания по други „руски въпроси“.

Въпреки това социалистите може отново да се озоват във властта. Не е ясно дали ще ги карат да се отрекат трижди от Путин и Кремъл – или ще е достатъчно просто да покажат прогресивно мислене в духа на интервюто по bTV на Андрей Гюров (ПП):

В ръцете на БСП е да реши зад кои принципи и идеи за управление на страната да застане – зад тези на новата „тройна коалиция“ или на прогресивните реформаторски сили.

Какво мисли останалата част от прогресивните сили – „Демократична България“ – за съюз с БСП, засега е неизвестно. Все пак социалистите подкрепиха законопроекта на ДБ при крайна необходимост държавата да може да поеме оперативен контрол над активите на „Лукойл“ в България, както и на всички други оператори на нефт и нефтопродукти.

Стендбай за еврото

Евро-атлантици в българската версия не значи и европейци. Европейската интеграция например беше опраскана по всички неписани уйдурми на българската парламентарна демокрация. Тези, които се кълняха в пътя към еврото, на практика го отрязаха. Законопроектите, подготвени от Министерството на финансите, които трябваше да бъдат гласувани – за промени в Кодекса за застраховане, за мерките срещу изпирането на пари и промени в Търговския закон – не минаха въпреки предупрежденията на финансовия министър Росица Велкова.

„Проблемът със „Зелена карта“ до такава степен е ескалирал, че е поставен като изискване за приемането ни в еврозоната“, каза Велкова. От 2018 г. на България е наложен мониторинг и виси заплахата да бъде изключена от системата „Зелена карта“, действаща в 48 държави, тъй като не плаща искания по „Гражданска отговорност“ срещу местни застрахователи заради пътни инциденти в чужбина.

Но въпреки че промяната в Кодекса за застраховане задължава бюрото „Зелена карта“ да спазва своя принцип „първо плащай, после оспорвай“, тя не мина. Тихата коалиция между ГЕРБ, ДПС, БСП, „Възраждане“ и „Български възход“ провали заседанието на Комисията по икономическа политика въпреки перманентни уверения на първите две партии, че са радетели за еврото.

Това се прави от хора, които не искат на този пазар да има европейска регулация… заради интересите на Алексей Петров („Лев Инс“, б.а.) и невъзможността на Бойко Борисов да се откъсне от своята биография плащаме данък минало, заяви по bTV съпредседателят на ДБ Христо Иванов.

Промените в Търговския закон, свързани с несъстоятелността – процес, с чиято тромавост и продължителност България се слави в Европа, също не се класираха за окончателно приемане в дневния ред на депутатите. През декември парламентът прие на първо четене законопроекта, който урежда и процедурата за фалит на лицата, които се занимават със стопанска дейност, но не са търговци. До второ не се стигна.

Възпрян за второ четене беше и законопроектът за мерките срещу изпирането на пари, срещу който възразиха някои работодателски организации и застрахователни компании, тъй като въвежда механизъм за идентифициране на лицата, предоставящи услуги по дружествено управление, и процедури за проверката им (адвокати, счетоводители, данъчни съветници и др.), както и допълнителни изисквания към прокуристи, управители, членове на управителни или контролни органи.

През април България трябва да поиска оценка на готовността си за присъединяване към еврозоната от 1 януари 2024 г., тоест да бъде оценено изпълнението на критериите. Но законодателните пропуски няма как да бъдат наваксани дотогава: парламентът се разпуска, изборите са на 2 април, 49-тото Народно събрание ще се конституира след седмица, има и великденски празници. Така че дори твърде високата инфлация в България да се охлади и задържи (критериите за дълга и дефицита са дерогирани), пакета закони, който се изисква, го няма. Влияние ще окаже и липсата на бюджет за 2023 г., с който върви и тригодишната бюджетна прогноза, необходими за конвергентен доклад.

Това е най-големият провал на 48-мия парламент – че направи всичко, за да осуети следващата стъпка за европейска интеграция на България, независимо от декларативните заявки и решение, с което задължи служебното правителство да ускори процеса и да започне информационна кампания (каквато правителството изобщо не начена въпреки подписката за референдум на „Възраждане“, разпалваща страховете от единната европейска валута).

Трохи за избирателите

Няма как да се мине без трохи за избирателите в година на поне два сигурни вота – предсрочни парламентарни, пети поред за две години, и местни избори наесен. Безплатни учебници, но от учебната 2024-та/2025-та, ще има и за по-големите ученици от VIII до ХII клас, а не само за тези от I до VII клас. Пак от догодина минималната работна заплата ще стане 50% от средната брутна работна заплата за предходните 12 месеца.

Парламентът успя да поправи и една несправедливост спрямо хората с увреждания – решенията на ТЕЛК ще важат до явяването на гражданите пред комисия, за да запазят правата си и инвалидната пенсия, която получават до преосвидетелстване. Сега НОИ спираше парите и в продължение на месеци, докато траеше процедурата, хората с увреждания бяха лишени от пенсии.

С огромно закъснение и ДПС предложи принудителният престой в затвори и места за задържане да се признава за трудов и осигурителен стаж при пенсиониране. Така стотици български мюсюлмани, репресирани по време на насилствената смяна на имената, ще получат, макар и незначително, увеличение на пенсиите си.

В последния момент парламентът гласува да има финансова помощ от държавата и за аптеки в отдалечени места, както и за единствените денонощни за даден район, които отпускат лекарства по Здравна каса през нощта. Тази мярка обаче може да се задейства, когато има нов бюджет.

Същото важи и за друга мярка – регулиране на възнагражденията на медиците в болниците, които не трябва да са по-ниски от договореното в колективния трудов договор. Причината е, че съдът отмени КТД от 2022 г., в който бяха заложени минимални заплати от 1500 лв. за медицинска сестра и 2000 лв. за лекар без специалност, и сестрите продължиха да получават мизерни възнаграждения.

В същото време служебното правителство на президента бележеше успех след успех. Пусна в експлоатация интерконектора с Гърция. Осигури количества втечнен газ и запълни газохранилището в Чирен. Получи от Европейската комисия първия транш от 1,2 млрд. евро по Плана за възстановяване и устойчивост – докато парламентът провали втория от 724 млн. евро, тъй като не успя да приеме необходимите закони начело с този за разследването на главния прокурор. Намери над 776 млн. лв., за да плати на пътни фирми за изграждане и поддръжка на пътищата в страната, от които близо 440 милиона са по договори, сключени още при третия кабинет на Бойко Борисов. Удължи енергийните помощи за бизнеса до март.

Президентът Радев и сръбският му колега Вучич поставиха началото на газовата връзка със Сърбия. Служебният кабинет се опитва да постави на енергийната карта нефтопровода Бургас–Александруполис заедно с гръцкото правителство. А същевременно извърши куп назначения на препоръчани неизвестно от кого хора на възлови места и с това бетонира кръга президентски назначения, започнал със смените в спецслужбите. Докато нито 47-мият, нито 48-мият парламент успя да изпълни задълженията си, обновявайки състава на регулатори, комисии и органи на съдебната власт с изтекъл от години мандат.

Същинската вреда от работата на 48-мото Народно събрание е именно в принизяването на парламентарната демокрация и инструментализирането ѝ от президента. Това покушение ще има дългосрочни последици.

„Частит“ да бъде този ден

Post Syndicated from original https://www.toest.bg/chastit-da-bude-tozi-den/

Наскоро прочетох някъде, че януари е най-пълният с празници месец и май наистина се оказва така. Започва се от първия ден, още с настъпването на новата година: на 1-ви е Васильовден, следват Йордановден и Ивановден (6-ти и 7-ми), към средата на месеца идват Антоновден и Атанасовден (17-ти и 18-ти), а към края му се падат имените дни на Григор и Живко (25-ти и 26-ти). Справка с календара показва, че буквално всеки втори ден от месеца се отбелязва нечий имен ден. Освен гореспоменатите, празнуващите също включват и много не толкова широко известни именици, като Силвия, Калчо, Евтим, Агнеса, Ксения, Тимотей и много други.

Освен имени дни, през януари се падат и други знайни и незнайни празници: Богоявление, Петльовден (Денят на мъжката рожба), Бабинден (Денят на родилната помощ), Събор на Седемдесетте апостоли, Кръстовден, Средзимие. Като добавим към тях и рождените дни и личните празници, неочаквани щастливи събития и придобивки, успех с някое и друго новогодишно решение, през целия януари пада едно голямо, почти всекидневно честване. Така че може би неслучайно през същия този месец се отбелязват и празниците на двете дейности, които най-често придружават честитенето: на 11-ти януари е Международният ден на думата „благодаря“, а на 21-ви е Денят на прегръдката.

Цялото това честитене и честване ме кара да се замисля за думата „честито“.

Макар на практика самата тя да е почти невидима, тъй като обикновено вниманието ми се концентрира върху празника, който придружава, думата „честито“ сама по себе си се оказва доста любопитна – както с употребата и приложенията си, така и с изненадващия си семантичен произход.

Българският тълковен речник дефинира „честит“ като: „1. Щастлив. Честито семейство. Царю честити! 2. При поздрави и благопожелания – да носи радост, да е на добро. Честита Нова година! Честит рожден ден!“ Това, което може би не става ясно от речниковата дефиниция, е

изключително широката приложимост на думата.

На български я използваме като благопожелание както за всеобщи празници (Честита Нова година! Честита Коледа! Честита Баба Марта! Честит 8 март!) и лични чествания (Честит рожден ден! Честит имен ден!), така и за персонални постижения и придобивки (Честито дипломиране! Честита награда! Честита книга! Честита сватба! Честито бебе! Честита нова кола!), а даже и за събития, за които нямаме никаква заслуга (Честит първи сняг! Честита пролет!), или пък като похвала за разни ежедневни дейности, които не заслужават внимание, а още по-малко поздравления (Честита баня! Честита прическа!). (Онзи ден дори видях във Facebook, че един познат е честитил на друг постижението, че се е сдобил с „евтини“ билети за представлението с Джон Малкович.)

За разлика от голямата разпространеност на думата „честито“ на български, в много други езици честитенето е доста по-нюансирано, така че различните случаи изискват различни думи.

Дори и в не особено софистицирания в това отношение английски се използват поне четири различни фрази за гореизброените случаи (Merry Christmas! Happy birthday! Congratulations! Best wishes!). Ситуацията във френския и немския не е много по-различна: Joyeux Noël ! Bon anniversaire ! Félicitations ! Meilleurs vœux ! / Frohe Weihnachten! Alles Gute zum Geburtstag! Herzlichen Glückwunsch!

На испански освен обичайните Felicidades (и производните им Feliz cumpleaños/Navidad/año nuevo) има и един интересен израз, за който научих неотдавна: Enhorabuena. Имайки предвид, че на испански съществителното обикновено се поставя преди модифициращото го прилагателно, буквалното значение на думата, разделена на отделните си съставки, е „на добър час“. Всъщност обаче тя чисто и просто означава „честито“, както я дефинира и речникът. Или не съвсем чисто и просто – според испаноговорещи приятели изразът се използва като поздравление за нещо, което човек е постигнал и за което има заслуга (нова работа, успешно взет изпит или пък раждането на дете), за разлика от обичайните felicitaciones, които се използват на рождени дни и други подобни, случващи се редовно и от само себе си празници. Проверка в речника показва, че „На добър час!“ на испански се превежда като Buena suerte, което пък обърнато в обратната посока се връща като „Kъсмет!“.

Идеята за късмет е заложена и в думата за „честито“ на македонски и сръбски (съответно „среќно“ и „срећно“), която се използва почти идентично като в българския език¹ и произлиза от думата „среќа“/„срећа“ (‘късмет, щастие’), а от своя страна тя е етимологично свързана със „среща“ (от праславянското *sъręťa, през старобългарското „сърѧща“)².

За съжаление, Институтът за български език при БАН все още не е стигнал до буквата Ч в изготвянето на многотомния „Български етимологичен речник“, но на няколко други места откривам потвърждение на широко разпространеното предположение, че

прилагателното „честито“ е семантично свързано с думата „чест“.

В „Словообразувателен речник на съвременния български книжовен език“ (1999) например думата „честит“ се появява в гнездото с връх „чест“. В това твърдение има някаква логика, ако гледаме на празника като на честване или случай за отдаване на чест – било то към рожденика, към някой светец или към определено събитие. Другатa възможна връзка, която откривам, е с думата „чест“, но като прилагателно, означаващо ‘редовен, повтарящ се през малки интервали’. Тази връзка, имайки предвид редовния характер на много от празниците, които си честитим, също ми се струва логична.

Тези предполагаеми етимологии обаче са отхвърлени от уважавания преподавател и изследовател по обща лингвистика и сравнително славянско и балканско езикознание проф. Людвиг Селимски, който твърди, че

думата „честит“ всъщност произлиза не от „чест“ (която на свой ред произлиза от старобългарското „чьсть“), а от „част“ (от старобългарското „чѧсть“, също означаващо ‘участ, съдба, дял’)³.

Според Селимски „поради претърпени с времето звукови промени основното чест- от състава на честит [като производно от думата честь ‘част; pars’] се е оказало в омонимно отношение спрямо днешното книжовно чест ‘honor’, с което го и смесваме“⁴. Като доказателство за аргумента си той използва, от една страна, разминаването в дефинициите: „… ако интересуващото ни честит е свързано по семантика с чест ‘honor’, неговото значение можеше да бъде дефинирано като „такъв, който има чест, honor“, както напр. именит ‘известен, прочут, с голямо име’.“ А то не е – както показва дефиницията, която цитирам по-горе. От друга страна, връзката с „част“ става ясно видима, когато помислим за „честит“ като синоним на „щастлив“: в своя „Речник на български език с тълкувание на български и руски думи“ (1895–1904) Найден Геров дефинира „честь“ като ‘добър случай, делба, среща, благотба, благополучие, щастие, късмет, бахт’ и – на руски – като ‘счастье, благополучие, судьба’.

Тъй като не съм лингвист, не мога да преценя доколко теорията на Селимски е достоверна, но така или иначе ми звучи убедително и със сигурност ми е интересна заради неочаквания ъгъл, който представя. Най-малкото – както забелязах вчера, докато честитях рождения ден на майка си – ме кара да се замисля върху вградените в думата „честит“ щастливи, а не честолюбиви пожелания, макар и те често да остават засенчени от празника, към който са прикрепени.

А накрая не ми остава друго, освен да пожелая честит рожден ден на „Тоест“ и много поводи за чествания на читателите му. За мен е чест да съм част от това начинание.

² Още нещо любопитно: за разлика от българския, сръбският и македонският имат различни думи за случайна среща („сусрек“/„средба“) и нарочна, уговорена среща („састанак“/„состанок“).

³ Освен произхода на думата „честит“, в публикацията си „Словообразуване и етимология“ (В: Ѕѣло, е-списание в областта на хуманитаристиката за българистични изследвания в периода Х–ХХI век, 2016, №7) Людвиг Селимски оспорва и широко приетите етимологии на думите „сцепление“ и „сношение“.

⁴ В умалителната на сръбски и македонски честица ‘частица’ е запазена непроменената гласна е.

В рубриката „От дума на дума“ Екатерина Петрова търси актуални, интересни или новопоявили се думи от нашето ежедневие и проследява често изненадващия им произход, развитието на значенията им във времето и взаимовръзките им с близки и далечни езици.

„Частит“ да бъде този ден

Post Syndicated from original https://www.toest.bg/chastit-da-bude-tozi-den/

Наскоро прочетох някъде, че януари е най-пълният с празници месец и май наистина се оказва така. Започва се от първия ден, още с настъпването на новата година: на 1-ви е Васильовден, следват Йордановден и Ивановден (6-ти и 7-ми), към средата на месеца идват Антоновден и Атанасовден (17-ти и 18-ти), а към края му се падат имените дни на Григор и Живко (25-ти и 26-ти). Справка с календара показва, че буквално всеки втори ден от месеца се отбелязва нечий имен ден. Освен гореспоменатите, празнуващите също включват и много не толкова широко известни именици, като Силвия, Калчо, Евтим, Агнеса, Ксения, Тимотей и много други.

Освен имени дни, през януари се падат и други знайни и незнайни празници: Богоявление, Петльовден (Денят на мъжката рожба), Бабинден (Денят на родилната помощ), Събор на Седемдесетте апостоли, Кръстовден, Средзимие. Като добавим към тях и рождените дни и личните празници, неочаквани щастливи събития и придобивки, успех с някое и друго новогодишно решение, през целия януари пада едно голямо, почти всекидневно честване. Така че може би неслучайно през същия този месец се отбелязват и празниците на двете дейности, които най-често придружават честитенето: на 11-ти януари е Международният ден на думата „благодаря“, а на 21-ви е Денят на прегръдката.

Цялото това честитене и честване ме кара да се замисля за думата „честито“.

Макар на практика самата тя да е почти невидима, тъй като обикновено вниманието ми се концентрира върху празника, който придружава, думата „честито“ сама по себе си се оказва доста любопитна – както с употребата и приложенията си, така и с изненадващия си семантичен произход.

Българският тълковен речник дефинира „честит“ като: „1. Щастлив. Честито семейство. Царю честити! 2. При поздрави и благопожелания – да носи радост, да е на добро. Честита Нова година! Честит рожден ден!“ Това, което може би не става ясно от речниковата дефиниция, е

изключително широката приложимост на думата.

На български я използваме като благопожелание както за всеобщи празници (Честита Нова година! Честита Коледа! Честита Баба Марта! Честит 8 март!) и лични чествания (Честит рожден ден! Честит имен ден!), така и за персонални постижения и придобивки (Честито дипломиране! Честита награда! Честита книга! Честита сватба! Честито бебе! Честита нова кола!), а даже и за събития, за които нямаме никаква заслуга (Честит първи сняг! Честита пролет!), или пък като похвала за разни ежедневни дейности, които не заслужават внимание, а още по-малко поздравления (Честита баня! Честита прическа!). (Онзи ден дори видях във Facebook, че един познат е честитил на друг постижението, че се е сдобил с „евтини“ билети за представлението с Джон Малкович.)

За разлика от голямата разпространеност на думата „честито“ на български, в много други езици честитенето е доста по-нюансирано, така че различните случаи изискват различни думи.

Дори и в не особено софистицирания в това отношение английски се използват поне четири различни фрази за гореизброените случаи (Merry Christmas! Happy birthday! Congratulations! Best wishes!). Ситуацията във френския и немския не е много по-различна: Joyeux Noël ! Bon anniversaire ! Félicitations ! Meilleurs vœux ! / Frohe Weihnachten! Alles Gute zum Geburtstag! Herzlichen Glückwunsch!

На испански освен обичайните Felicidades (и производните им Feliz cumpleaños/Navidad/año nuevo) има и един интересен израз, за който научих неотдавна: Enhorabuena. Имайки предвид, че на испански съществителното обикновено се поставя преди модифициращото го прилагателно, буквалното значение на думата, разделена на отделните си съставки, е „на добър час“. Всъщност обаче тя чисто и просто означава „честито“, както я дефинира и речникът. Или не съвсем чисто и просто – според испаноговорещи приятели изразът се използва като поздравление за нещо, което човек е постигнал и за което има заслуга (нова работа, успешно взет изпит или пък раждането на дете), за разлика от обичайните felicitaciones, които се използват на рождени дни и други подобни, случващи се редовно и от само себе си празници. Проверка в речника показва, че „На добър час!“ на испански се превежда като Buena suerte, което пък обърнато в обратната посока се връща като „Kъсмет!“.

Идеята за късмет е заложена и в думата за „честито“ на македонски и сръбски (съответно „среќно“ и „срећно“), която се използва почти идентично като в българския език¹ и произлиза от думата „среќа“/„срећа“ (‘късмет, щастие’), а от своя страна тя е етимологично свързана със „среща“ (от праславянското *sъręťa, през старобългарското „сърѧща“)².

За съжаление, Институтът за български език при БАН все още не е стигнал до буквата Ч в изготвянето на многотомния „Български етимологичен речник“, но на няколко други места откривам потвърждение на широко разпространеното предположение, че

прилагателното „честито“ е семантично свързано с думата „чест“.

В „Словообразувателен речник на съвременния български книжовен език“ (1999) например думата „честит“ се появява в гнездото с връх „чест“. В това твърдение има някаква логика, ако гледаме на празника като на честване или случай за отдаване на чест – било то към рожденика, към някой светец или към определено събитие. Другатa възможна връзка, която откривам, е с думата „чест“, но като прилагателно, означаващо ‘редовен, повтарящ се през малки интервали’. Тази връзка, имайки предвид редовния характер на много от празниците, които си честитим, също ми се струва логична.

Тези предполагаеми етимологии обаче са отхвърлени от уважавания преподавател и изследовател по обща лингвистика и сравнително славянско и балканско езикознание проф. Людвиг Селимски, който твърди, че

думата „честит“ всъщност произлиза не от „чест“ (която на свой ред произлиза от старобългарското „чьсть“), а от „част“ (от старобългарското „чѧсть“, също означаващо ‘участ, съдба, дял’)³.

Според Селимски „поради претърпени с времето звукови промени основното чест- от състава на честит [като производно от думата честь ‘част; pars’] се е оказало в омонимно⁴ отношение спрямо днешното книжовно чест ‘honor’, с което го и смесваме“⁵. Като доказателство за аргумента си той използва, от една страна, разминаването в дефинициите: „… ако интересуващото ни честит е свързано по семантика с чест ‘honor’, неговото значение можеше да бъде дефинирано като „такъв, който има чест, honor“, както напр. именит ‘известен, прочут, с голямо име’.“ А то не е – както показва дефиницията, която цитирам по-горе. От друга страна, връзката с „част“ става ясно видима, когато помислим за „честит“ като синоним на „щастлив“: в своя „Речник на български език с тълкувание на български и руски думи“ (1895–1904) Найден Геров дефинира „честь“ като ‘добър случай, делба, среща, благотба, благополучие, щастие, късмет, бахт’ и – на руски – като ‘счастье, благополучие, судьба’.

Тъй като не съм лингвист, не мога да преценя доколко теорията на Селимски е достоверна, но така или иначе ми звучи убедително и със сигурност ми е интересна заради неочаквания ъгъл, който представя. Най-малкото – както забелязах вчера, докато честитях рождения ден на майка си – ме кара да се замисля върху вградените в думата „честит“ щастливи, а не честолюбиви пожелания, макар и те често да остават засенчени от празника, към който са прикрепени.

А накрая не ми остава друго, освен да пожелая честит рожден ден на „Тоест“ и много поводи за чествания на читателите му. За мен е чест да съм част от това начинание.

² Още нещо любопитно: за разлика от българския, сръбският и македонският имат различни думи за случайна среща („сусрек“/„средба“) и нарочна, уговорена среща („састанак“/„состанок“).

³ Освен произхода на думата „честит“, в публикацията си „Словообразуване и етимология“ (В: Ѕѣло, е-списание в областта на хуманитаристиката за българистични изследвания в периода Х–ХХI век, 2016, №7) Людвиг Селимски оспорва и широко приетите етимологии на думите „сцепление“ и „сношение“.

⁴ Тоест написано и произнасяно по един и същ начин, но с различно значение.

⁵ В умалителната на сръбски и македонски честица ‘частица’ е запазена непроменената гласна е.

В рубриката „От дума на дума“ Екатерина Петрова търси актуални, интересни или новопоявили се думи от нашето ежедневие и проследява често изненадващия им произход, развитието на значенията им във времето и взаимовръзките им с близки и далечни езици.

Size Comparisons

Post Syndicated from original https://xkcd.com/2733/

The Document Foundation announces LibreOffice 7.5 Community

Post Syndicated from original https://lwn.net/Articles/922051/

Version 7.5 of the LibreOffice Community edition is now available. LibreOffice is, of course, the FOSS desktop office suite; version 7.5 brings new features to multiple parts of the tool, including major improvements to dark mode, better PDF exports, improved bookmarks in Writer, data tables for charts in Calc, better interoperability with Microsoft Office, and lots more.

Check out the release notes for further information.

LibreOffice 7.5 Community’s new features have been developed by 144

contributors: 63% of code commits are from the 47 developers employed by

three companies sitting in TDF’s Advisory Board – Collabora, Red Hat and

allotropia – or other organizations, 12% are from 6 developers at The

Document Foundation, and the remaining 25% are from 91 individual

volunteers.Other 112 volunteers – representing hundreds of other people providing

translations – have committed localizations in 158 languages. LibreOffice

7.5 Community is released in 120 different language versions, more than any

other free or proprietary software, and as such can be used in the native

language (L1) by over 5.4 billion people worldwide. In addition, over 2.3

billion people speak one of those 120 languages as their second language

(L2).

Analyze Amazon S3 storage costs using AWS Cost and Usage Reports, Amazon S3 Inventory, and Amazon Athena

Post Syndicated from Dagar Katyal original https://aws.amazon.com/blogs/big-data/analyze-amazon-s3-storage-costs-using-aws-cost-and-usage-reports-amazon-s3-inventory-and-amazon-athena/

Since its launch in 2006, Amazon Simple Storage Service (Amazon S3) has experienced major growth, supporting multiple use cases such as hosting websites, creating data lakes, serving as object storage for consumer applications, storing logs, and archiving data. As the application portfolio grows, customers tend to store data from multiple application and different business functions in a single S3 bucket, which can grow the storage in S3 buckets to hundreds of TBs. The AWS Billing console provides a way to look at the total storage cost of data stored in Amazon S3, but sometimes IT organizations need to understand the breakdown of costs of a particular S3 bucket by various prefixes or objects corresponding to a particular user or application. There are various reasons to analyze the costs of S3 buckets, such as to identify the spend breakdown, do internal chargebacks, understand the cost breakdown by business unit and application, and many more. As of this writing, there is no easy way to do a cost breakdown of S3 buckets by objects and prefixes.

In this post, we discuss a solution using Amazon Athena to query AWS Cost and Usage Reports and Amazon S3 Inventory reports to analyze the cost by prefixes and objects in an S3 bucket.

Overview of solution

The following figure shows the architecture for this solution. First, we enable the AWS Cost and Usage Reports (AWS CUR) and Amazon S3 Inventory features, which save the output into two separate pre-created S3 buckets. We then use Athena to query these S3 buckets for AWS CUR data and S3 object inventory data to correlate and allocate the cost breakdown at the object or prefix level.

To implement the solution, we complete the following steps:

- Create S3 buckets for AWS CUR, S3 object inventory, and Athena results. Alternatively, you can create these respective buckets when enabling the respective individual features, but for the purpose of this post, we create all of them at the beginning.

- Enable the Cost and Usage Reports.

- Enable Amazon S3 Inventory configuration.

- Create AWS Glue Data Catalog tables for the CUR and S3 object inventory to query using Athena.

- Run queries in Athena.

Prerequisites

For this walkthrough, you should have the following prerequisites:

- An AWS account.

- AWS Identity and Access Management (IAM) permissions for the following services:

- Amazon S3 – Create and manage S3 buckets.

- AWS Billing and Cost Management – Create Cost and Usage Reports.

- Athena – Create tables and run queries. AWS Glue Data Catalog permissions are needed to create tables.

Create S3 buckets

Amazon S3 is an object storage service offering industry-leading scalability, data availability, security, and performance. Customers of all sizes and industries can store and protect any amount of data for virtually any use case, such as data lakes, cloud-native applications, and mobile apps. With cost-effective storage classes and easy-to-use management features, you can optimize costs, organize data, and configure fine-tuned access controls to meet specific business, organizational, and compliance requirements.

For this post, we use the S3 bucket s3-object-cost-allocation as the primary bucket for cost allocation. This S3 bucket is conveniently modeled to contain several prefixes and objects of different sizes for which cost allocation needs to be done based on the overall cost of the bucket. In a real-world scenario, you should use a bucket that has data for multiple teams and for which you need to allocate costs by prefix or object. Going forward, we refer to this bucket as the primary object bucket.

The following screenshot shows our S3 bucket and folders.

Now let’s create the three additional operational S3 buckets to store the datasets generated to calculate costs for the objects. You can create the following buckets or any existing buckets as needed:

cur-cost-usage-reports-<account_number>– This bucket is used to save the Cost and Usage Reports for the account.S3-inventory-configurations-<account_number>– This bucket is used to save the inventory configurations of our primary object bucket.athena-query-bucket-<account_number>– This bucket is used to save the query results from Athena.

Complete the following steps to create your S3 buckets:

- On the Amazon S3 console, choose Buckets in the navigation pane.

- Choose Create bucket.

- For Bucket name, enter the name of your bucket (

cur-cost-usage-reports-<account_number>). - For AWS Region, choose your preferred Region.

- Leave all other settings at default (or according to your organization’s standards).

- Choose Create bucket.

- Repeat these steps to create

s3-inventory-configurations-<account_number>andathena-query-bucket-<account_number>.

Enable the Cost and Usage Reports

The AWS Cost and Usage Reports (AWS CUR) contains the most comprehensive set of cost and usage data available. You can use Cost and Usage Reports to publish your AWS billing reports to an S3 bucket that you own. You can receive reports that break down your costs by the hour, day, or month; by product or product resource; or by tags that you define yourself.

Complete the following steps to enable Cost and Usage Reports for your account:

- On the AWS Billing console, in the navigation pane, choose Cost & Usage Reports.

- Choose Create report.

- For Report name, enter a name for your report, such as

account-cur-s3. - For Additional report details, select Include resource IDs to include the IDs of each individual resource in the report.Including resource IDs will create individual line items for each of your resources. This can increase the size of your Cost and Usage Reports files significantly, which can affect the S3 storage costs for your CUR, based on your AWS usage. We need this feature enabled for this post.

- For Data refresh settings, select whether you want the Cost and Usage Reports to refresh if AWS applies refunds, credits, or support fees to your account after finalizing your bill.When a report refreshes, a new report is uploaded to Amazon S3.

- Choose Next.

- For S3 bucket, choose Configure.

- For Configure S3 Bucket, select an existing bucket created in the previous section (

cur-cost-usage-reports-<account_number>) and choose Next. - Review the bucket policy, select I have confirmed that this policy is correct, and choose Save. This default bucket policy provides Cost and Usage Reports access to write data to Amazon S3.

- For Report path prefix, enter

cur-data/account-cur-daily. - For Time granularity, choose Daily.

- For Report versioning, choose Overwrite existing report.

- For Enable report data integration for, select Amazon Athena.

- Choose Next.

- After you have reviewed the settings for your report, choose Review and Complete.

The Cost and Usage reports will be delivered to the S3 buckets within 24 hours.

The following sample CUR in CSV format shows different columns of the Cost and Usage Report, including bill_invoice_id, bill_invoicing_entity, bill_payer_account_id, and line_item_product_code, to name a few.

Enable Amazon S3 Inventory configuration

Amazon S3 Inventory is one of the tools Amazon S3 provides to help manage your storage. You can use it to audit and report on the replication and encryption status of your objects for business, compliance, and regulatory needs. Amazon S3 Inventory provides comma-separated values (CSV), Apache Optimized Row Columnar (ORC), or Apache Parquet output files that list your objects and their corresponding metadata on a daily or weekly basis for an S3 bucket or a shared prefix (objects that have names that begin with a common string).

Complete the following steps to enable Amazon S3 Inventory on the primary object bucket:

- On the Amazon S3 console, choose Buckets in the navigation pane.

- Choose the bucket for which you want to configure Amazon S3 Inventory.

This will be the existing bucket in your account that has data that needs to be analyzed. This could be your data lake or application S3 bucket. We created the buckets3-object-cost-allocationwith some sample data and folder structure. - Choose Management.

- Under Inventory configurations, choose Create inventory configuration.

- For Inventory configuration name, enter

s3-object-cost-allocation. - For Inventory scope, leave Prefix blank.

This is to ensure that all objects are covered for the report. - For Object Versions, select Current version only.

- For Report details, choose This account.

- For Destination, choose the destination bucket we created (

s3-inventory-configurations-<account_number>). - For Frequency, choose Daily.

- For Output format, choose as Apache Parquet.

- For Status, choose Enable.

- Keep server-side encryption disabled. To use server-side encryption, choose Enable and specify the encryption key.

- For Additional fields, select the following to add to the inventory report:

- Size – The object size in bytes.

- Last modified date – The object creation date or the last modified date, whichever is the latest.

- Multipart upload – Specifies that the object was uploaded as a multipart upload. For more information, see Uploading and copying objects using multipart upload.

- Replication status – The replication status of the object. For more information, see Using the S3 console.

- Encryption status – The server-side encryption used to encrypt the object. For more information, see Protecting data using server-side encryption.

- Bucket key status – Indicates whether a bucket-level key generated by AWS KMS applies to the object.

- Storage class – The storage class used for storing the object.

- Intelligent-Tiering: Access tier – Indicates the access tier of the object if it was stored in Intelligent-Tie

- Choose Create.

It may take up to 48 hours to deliver the first report.

Create AWS Glue Data Catalog tables for CUR and Amazon S3 Inventory reports

Wait for up to 48 hours for the previous step to generate the reports. In this section, we use Athena to create and define AWS Glue Data Catalog tables for the data that has been created using Cost and Usage Reports and Amazon S3 Inventory reports.

Athena is a serverless, interactive analytics service built on open-source frameworks, supporting open-table and file formats. Athena provides a simplified, flexible way to analyze petabytes of data where it lives.

Complete the following steps to create the tables using Athena:

- Navigate to the Athena console.

- If you’re using Athena for the first time, you need to set up a query result location in Amazon S3. If you preconfigured this in Athena , you can skip this step.

- Choose View settings.

- Choose Manage.

- In the section Query result location and encryption, choose Browse S3 and choose the bucket that we created (

athena-query-bucket-<account_number>). - Choose Save.

- Navigate back to the Athena query editor.

- Choose View settings.

- Run the following query in Athena to create a table for Cost and Usage Reports. Verify and update the section for <<LOCATION>> at the end of the query and point it to the correct S3 bucket and location. Note that the new table name should be

account_cur.CREATE EXTERNAL TABLE `account_cur`( `identity_line_item_id` string, `identity_time_interval` string, `bill_invoice_id` string, `bill_billing_entity` string, `bill_bill_type` string, `bill_payer_account_id` string, `bill_billing_period_start_date` timestamp, `bill_billing_period_end_date` timestamp, `line_item_usage_account_id` string, `line_item_line_item_type` string, `line_item_usage_start_date` timestamp, `line_item_usage_end_date` timestamp, `line_item_product_code` string, `line_item_usage_type` string, `line_item_operation` string, `line_item_availability_zone` string, `line_item_resource_id` string, `line_item_usage_amount` double, `line_item_normalization_factor` double, `line_item_normalized_usage_amount` double, `line_item_currency_code` string, `line_item_unblended_rate` string, `line_item_unblended_cost` double, `line_item_blended_rate` string, `line_item_blended_cost` double, `line_item_line_item_description` string, `line_item_tax_type` string, `line_item_legal_entity` string, `product_product_name` string, `product_availability` string, `product_description` string, `product_durability` string, `product_event_type` string, `product_fee_code` string, `product_fee_description` string, `product_free_query_types` string, `product_from_location` string, `product_from_location_type` string, `product_from_region_code` string, `product_group` string, `product_group_description` string, `product_location` string, `product_location_type` string, `product_message_delivery_frequency` string, `product_message_delivery_order` string, `product_operation` string, `product_platopricingtype` string, `product_product_family` string, `product_queue_type` string, `product_region` string, `product_region_code` string, `product_servicecode` string, `product_servicename` string, `product_sku` string, `product_storage_class` string, `product_storage_media` string, `product_to_location` string, `product_to_location_type` string, `product_to_region_code` string, `product_transfer_type` string, `product_usagetype` string, `product_version` string, `product_volume_type` string, `pricing_rate_code` string, `pricing_rate_id` string, `pricing_currency` string, `pricing_public_on_demand_cost` double, `pricing_public_on_demand_rate` string, `pricing_term` string, `pricing_unit` string, `reservation_amortized_upfront_cost_for_usage` double, `reservation_amortized_upfront_fee_for_billing_period` double, `reservation_effective_cost` double, `reservation_end_time` string, `reservation_modification_status` string, `reservation_normalized_units_per_reservation` string, `reservation_number_of_reservations` string, `reservation_recurring_fee_for_usage` double, `reservation_start_time` string, `reservation_subscription_id` string, `reservation_total_reserved_normalized_units` string, `reservation_total_reserved_units` string, `reservation_units_per_reservation` string, `reservation_unused_amortized_upfront_fee_for_billing_period` double, `reservation_unused_normalized_unit_quantity` double, `reservation_unused_quantity` double, `reservation_unused_recurring_fee` double, `reservation_upfront_value` double, `savings_plan_total_commitment_to_date` double, `savings_plan_savings_plan_a_r_n` string, `savings_plan_savings_plan_rate` double, `savings_plan_used_commitment` double, `savings_plan_savings_plan_effective_cost` double, `savings_plan_amortized_upfront_commitment_for_billing_period` double, `savings_plan_recurring_commitment_for_billing_period` double, `resource_tags_user_bucket_name` string, `resource_tags_user_cost_tracking` string) PARTITIONED BY ( `year` string, `month` string) ROW FORMAT SERDE 'org.apache.hadoop.hive.ql.io.parquet.serde.ParquetHiveSerDe' STORED AS INPUTFORMAT 'org.apache.hadoop.mapred.TextInputFormat' OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.HiveIgnoreKeyTextOutputFormat' LOCATION '<<LOCATION>>' - Run the following query in Athena to create the table for Amazon S3 Inventory. Verify and update the section for <<LOCATION>> at the end of the query and point it to the correct S3 bucket and location.

- To get the exact value of the location, navigate to the bucket where inventory configurations are stored and navigate to the folder path

Hive. Use the S3 URI to replace <<LOCATION>> in the query.

CREATE EXTERNAL TABLE s3_object_inventory( bucket string, key string, version_id string, is_latest boolean, is_delete_marker boolean, size bigint, last_modified_date bigint, storage_class string, is_multipart_uploaded boolean, replication_status string, encryption_status string, intelligent_tiering_access_tier string, bucket_key_status string ) PARTITIONED BY ( dt string ) ROW FORMAT SERDE 'org.apache.hadoop.hive.ql.io.parquet.serde.ParquetHiveSerDe' STORED AS INPUTFORMAT 'org.apache.hadoop.hive.ql.io.SymlinkTextInputFormat' OUTPUTFORMAT 'org.apache.hadoop.hive.ql.io.IgnoreKeyTextOutputFormat' LOCATION '<<LOCATION>>';

- To get the exact value of the location, navigate to the bucket where inventory configurations are stored and navigate to the folder path

- We need to refresh the partitions and add new inventory lists to the table. Use the following commands to add data to the CUR table and Amazon S3 Inventory table:

MSCK REPAIR TABLE `account_cur`; MSCK REPAIR TABLE s3_object_inventory;

Run queries in Athena to allocate the cost of objects in an S3 bucket

Now we can query the data we have available to get a cost allocation breakdown at the prefix level.

We need to provide some information in the following queries:

- Update <<YYYY-MM-DD>> with the date for which you want to analyze the data

- Update <<prefix>> with the prefix values for your bucket that needs to be analyzed

- Update <<bucket_name>> with the name of the bucket that needs to be analyzed

We use the following part of the query to calculate the size of storage being used by the target prefix that we want to calculate the cost for:

select date_parse(dt,'%Y-%m-%d-%H-%i') dt, cast (sum(size) as double) targetPrefixBytes

from s3_object_inventory

where date_parse(dt,'%Y-%m-%d-%H-%i') = cast('<<YYYY-MM-DD>>' as timestamp)

and key like '<<prefix>>/%'

group by dtNext, we calculate the total size of the bucket on that particular date:

select date_parse(dt,'%Y-%m-%d-%H-%i') dt, cast (sum(size) as double) totalBytes

from s3_object_inventory

where date_parse(dt,'%Y-%m-%d-%H-%i') = cast('<<YYYY-MM-DD>>' as timestamp)

group by dtWe query the CUR table to get the cost of a particular bucket on a particular date:

select line_item_usage_start_date as dt, sum(line_item_blended_cost) as line_item_blended_cost

from "account_cur"

where line_item_product_code = 'AmazonS3'

and product_servicecode = 'AmazonS3'

and line_item_operation = 'StandardStorage'

and line_item_resource_id = '<<bucket_name>>'

and line_item_usage_start_date = cast('<<YYYY-MM-DD>>' as timestamp)

group by line_item_usage_start_datePutting all of this together, we can calculate the cost of a particular prefix (folder or a file) on a specific date. The complete query is as follows:

with

cost as (select line_item_usage_start_date as dt, sum(line_item_blended_cost) as line_item_blended_cost

from "account_cur"

where line_item_product_code = 'AmazonS3'

and product_servicecode = 'AmazonS3'

and line_item_operation = 'StandardStorage'

and line_item_resource_id = '<<bucket_name>>'

and line_item_usage_start_date = cast('<<YYYY-MM-DD>>' as timestamp)

group by line_item_usage_start_date),

total as (select date_parse(dt,'%Y-%m-%d-%H-%i') dt, cast (sum(size) as double) totalBytes

from s3_object_inventory

where date_parse(dt,'%Y-%m-%d-%H-%i') = cast('<<YYYY-MM-DD>>' as timestamp)

group by dt),

target as (select date_parse(dt,'%Y-%m-%d-%H-%i') dt, cast (sum(size) as double) targetPrefixBytes

from s3_object_inventory

where date_parse(dt,'%Y-%m-%d-%H-%i') = cast('<<YYYY-MM-DD>>' as timestamp)

and key like '<<prefix>>/%'

group by dt)

select target.dt,

(target.targetPrefixBytes/ total.totalBytes * 100) percentUsed,

cost.line_item_blended_cost totalCost,

cost.line_item_blended_cost*(target.targetPrefixBytes/ total.totalBytes) as prefixCost

from target, total, cost

where target.dt = total.dt

and target.dt = cost.dtThe following screenshot shows the results table for the sample data we used in this post. We get the following information:

- dt – Date

- percentUsed – The percentage of prefix space compared to overall bucket space

- totalCost – The total cost of the bucket

- prefixCost – The cost of the space used by the prefix

Clean up

To stop incurring costs, be sure to disable Amazon S3 Inventory and Cost and Usage Reports when you’re done.

Delete the S3 buckets created for the Amazon S3 Inventory reports and Cost and Usage Reports to avoid storage charges.

Other methods for Amazon S3 storage analysis

Amazon S3 Storage Lens can provide a single view of object storage usage and activity across your entire Amazon S3 storage. With S3 Storage Lens, you can understand, analyze, and optimize storage with over 29 usage and activity metrics and interactive dashboards to aggregate data for your entire organization, specific accounts, Regions, buckets, or prefixes. All of this data is accessible on the Amazon S3 console or as raw data in an S3 bucket.